В этой статье пример оптимального, на мой взгляд, кода для файла robots.txt под WordPress, который вы можете использовать в своих сайтах.

Для начала, вспомним зачем нужен robots.txt - файл robots.txt нужен исключительно для поисковых роботов, чтобы «сказать» им какие разделы/страницы сайта посещать, а какие посещать не нужно. Страницы, которые закрыты от посещения не будут попадать в индекс поисковиков (Yandex, Google и т.д.).

Вариант 1: оптимальный код robots.txt для WordPress

User-agent: * Disallow: /cgi-bin # классика... Disallow: /? # все параметры запроса на главной Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins Disallow: *?s= # поиск Disallow: *&s= # поиск Disallow: /search # поиск Disallow: /author/ # архив автора Disallow: */embed # все встраивания Disallow: */page/ # все виды пагинации Allow: */uploads # открываем uploads Allow: /*/*.js # внутри /wp- (/*/ - для приоритета) Allow: /*/*.css # внутри /wp- (/*/ - для приоритета) Allow: /wp-*.png # картинки в плагинах, cache папке и т.д. Allow: /wp-*.jpg # картинки в плагинах, cache папке и т.д. Allow: /wp-*.jpeg # картинки в плагинах, cache папке и т.д. Allow: /wp-*.gif # картинки в плагинах, cache папке и т.д. Allow: /wp-*.svg # картинки в плагинах, cache папке и т.д. Allow: /wp-*.pdf # файлы в плагинах, cache папке и т.д. Allow: /wp-admin/admin-ajax.php #Disallow: /wp/ # когда WP установлен в подкаталог wp Sitemap: http://example.com/sitemap.xml Sitemap: http://example.com/sitemap2.xml # еще один файл #Sitemap: http://example.com/sitemap.xml.gz # сжатая версия (.gz) # Версия кода: 1.1 # Не забудьте поменять `site.ru` на ваш сайт.Разбор кода:

- Disallow: /cgi-bin - закрывает каталог скриптов на сервере

- Disallow: /feed - закрывает RSS фид блога

- Disallow: /trackback - закрывает уведомления

- Disallow: ?s= или Disallow: *?s= - закрыавет страницы поиска

- Disallow: */page/ - закрывает все виды пагинации

Правило Sitemap: http://example.com/sitemap.xml указывает роботу на файл с картой сайта в формате XML. Если у вас на сайте есть такой файл, то пропишите полный путь к нему. Таких файлов может быть несколько, тогда указываем путь к каждому отдельно.

В строке Host: site.ru мы указываем главное зеркало сайта. Если у сайта существуют зеркала (копии сайта на других доменах), то чтобы Яндекс индексировал всех их одинаково, нужно указывать главное зеркало. Директива Host: понимает только Яндекс, Google не понимает! Если сайт работает под https протоколом, то его обязательно нужно указать в Host: Host: http://example.com

Из документации Яндекса: «Host - независимая директива и работает в любом месте файла (межсекционная)». Поэтому её ставим наверх или в самый конец файла, через пустую строку.

В строке User-agent: * мы указываем, что все нижеприведенные правила будут работать для всех поисковых роботов * . Если нужно, чтобы эти правила работали только для одного, конкретного робота, то вместо * указываем имя робота (User-agent: Yandex , User-agent: Googlebot).

В строке Allow: */uploads мы намеренно разрешаем индексировать страницы, в которых встречается /uploads . Это правило обязательно, т.к. выше мы запрещаем индексировать страницы начинающихся с /wp- , а /wp- входит в /wp-content/uploads . Поэтому, чтобы перебить правило Disallow: /wp- нужна строчка Allow: */uploads , ведь по ссылкам типа /wp-content/uploads/... у нас могут лежать картинки, которые должны индексироваться, так же там могут лежать какие-то загруженные файлы, которые незачем скрывать. Allow: может быть "до" или "после" Disallow: .

Остальные строчки запрещают роботам "ходить" по ссылкам, которые начинаются с:

Потому что наличие открытых фидов требуется например для Яндекс Дзен, когда нужно подключить сайт к каналу (спасибо комментатору «Цифровой»). Возможно открытые фиды нужны где-то еще.

В тоже время, фиды имеют свой формат в заголовках ответа, благодаря которому поисковики понимают что это не HTML страница, а фид и, очевидно, обрабатывают его как-то иначе.

Директива Host для Яндекса больше не нужна

Яндекс полностью отказывается от директивы Host, её заменил 301 редирект. Host можно смело удалять из robots.txt . Однако важно, чтобы на всех зеркалах сайта стоял 301 редирект на главный сайт (главное зеркало).

Это важно: сортировка правил перед обработкой

Yandex и Google обрабатывает директивы Allow и Disallow не по порядку в котором они указаны, а сначала сортирует их от короткого правила к длинному, а затем обрабатывает последнее подходящее правило:

User-agent: * Allow: */uploads Disallow: /wp-

будет прочитана как:

User-agent: * Disallow: /wp- Allow: */uploads

Чтобы быстро понять и применять особенность сортировки, запомните такое правило: «чем длиннее правило в robots.txt, тем больший приоритет оно имеет. Если длина правил одинаковая, то приоритет отдается директиве Allow.»

Вариант 2: стандартный robots.txt для WordPress

Не знаю кто как, а я за первый вариант! Потому что он логичнее - не надо полностью дублировать секцию ради того, чтобы указать директиву Host для Яндекса, которая является межсекционной (понимается роботом в любом месте шаблона, без указания к какому роботу она относится). Что касается нестандартной директивы Allow , то она работает для Яндекса и Гугла и если она не откроет папку uploads для других роботов, которые её не понимают, то в 99% ничего опасного это за собой не повлечет. Я пока не заметил что первый robots работает не так как нужно.

Вышеприведенный код немного не корректный. Спасибо комментатору " " за указание на некорректность, правда в чем она заключалась пришлось разбираться самому. И вот к чему я пришел (могу ошибаться):

- Директиву Яндекса Host: нужно использовать после Disallow: , потому что некоторые роботы (не Яндекса и Гугла), могут не понять её и вообще забраковать robots.txt. Cамому же Яндексу, судя по документации , абсолютно все равно где и как использовать Host: , хоть вообще создавай robots.txt с одной только строчкой Host: www.site.ru , для того, чтобы склеить все зеркала сайта.

Некоторые роботы (не Яндекса и Гугла) - не понимают более 2 директив: User-agent: и Disallow:

3. Sitemap: межсекционная директива для Яндекса и Google и видимо для многих других роботов тоже, поэтому её пишем в конце через пустую строку и она будет работать для всех роботов сразу.

На основе этих поправок, корректный код должен выглядеть так:

User-agent: Yandex Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-json/ Disallow: /wp-login.php Disallow: /wp-register.php Disallow: */embed Disallow: */page/ Disallow: /cgi-bin Disallow: *?s= Allow: /wp-admin/admin-ajax.php Host: site.ru User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-json/ Disallow: /wp-login.php Disallow: /wp-register.php Disallow: */embed Disallow: */page/ Disallow: /cgi-bin Disallow: *?s= Allow: /wp-admin/admin-ajax.php Sitemap: http://example.com/sitemap.xmlДописываем под себя

Если вам нужно запретить еще какие-либо страницы или группы страниц, можете внизу добавить правило (директиву) Disallow: . Например, нам нужно закрыть от индексации все записи в категории news , тогда перед Sitemap: добавляем правило:

Disallow: /news

Оно запретить роботам ходить по подобным ссылками:

- http://example.com/news

- http://example.com/news/drugoe-nazvanie/

Если нужно закрыть любые вхождения /news , то пишем:

Disallow: */news

- http://example.com/news

- http://example.com/my/news/drugoe-nazvanie/

- http://example.com/category/newsletter-nazvanie.html

Подробнее изучить директивы robots.txt вы можете на странице помощи Яндекса (но имейте ввиду, что не все правила, которые описаны там, работают для Google).

Проверка robots.txt и документация

Проверить правильно ли работают прописанные правила можно по следующим ссылкам:

- Яндекс: http://webmaster.yandex.ru/robots.xml .

- В Google это делается в Search console . Нужна авторизация и наличия сайта в панели веб-мастера...

- Сервис для создания файла robots.txt: http://pr-cy.ru/robots/

- Сервис для создания и проверки robots.txt: https://seolib.ru/tools/generate/robots/

Я спросил у Яндекса...

Задал вопрос в тех. поддержку Яндекса насчет межсекционного использования директив Host и Sitemap:

Вопрос:

Здравствуйте!

Пишу статью насчет robots.txt на своем блоге. Хотелось бы получить ответ на такой вопрос (в документации я не нашел однозначного "да"):Если мне нужно склеить все зеркала и для этого я использую директиву Host в самом начале фала robots.txt:

Host: site.ru User-agent: * Disallow: /asd

Будет ли в данном примере правильно работать Host: site.ru? Будет ли она указывать роботам что site.ru это основное зеркало. Т.е. эту директиву я использую не в секции, а отдельно (в начале файла) без указания к какому User-agent она относится.

Также хотел узнать, обязательно ли директиву Sitemap нужно использовать внутри секции или можно использовать за пределами: например, через пустую строчку, после секции?

User-agent: Yandex Disallow: /asd User-agent: * Disallow: /asd Sitemap: http://example.com/sitemap.xml

Поймет ли робот в данном примере директиву Sitemap?

Надеюсь получить от вас ответ, который поставит жирную точку в моих сомнениях.

Ответ:

Здравствуйте!

Директивы Host и Sitemap являются межсекционными, поэтому будут использоваться роботом вне зависимости от места в файле robots.txt, где они указаны.

--

С уважением, Платон Щукин

Служба поддержки Яндекса

Заключение

Важно помнить, что изменения в robots.txt на уже рабочем сайте будут заметны только спустя несколько месяцев (2-3 месяца).

Ходят слухи, что Google иногда может проигнорировать правила в robots.txt и взять страницу в индекс, если сочтет, что страница ну очень уникальная и полезная и она просто обязана быть в индексе. Однако другие слухи опровергают эту гипотезу тем, что неопытные оптимизаторы могут неправильно указать правила в robots.txt и так закрыть нужные страницы от индексации и оставить ненужные. Я больше склоняюсь ко второму предположению...

Динамический robots.txt

В WordPress запрос на файл robots.txt обрабатывается отдельно и совсем не обязательно физически создавать файл robots.txt в корне сайта, более того это не рекомендуется, потому что при таком подходе плагинам будет очень сложно изменить этот файл, а это иногда нужно.

О том как работает динамическое создание файла robots.txt читайте в описании функции , а ниже я приведу пример как можно изменить содержание этого файла, налету, через хук .

Для этого добавьте следующий код в файл functions.php:

Add_action("do_robotstxt", "my_robotstxt"); function my_robotstxt(){ $lines = [ "User-agent: *", "Disallow: /wp-admin/", "Disallow: /wp-includes/", "", ]; echo implode("\r\n", $lines); die; // обрываем работу PHP }

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/

Crawl-delay - таймаут для сумасшедших роботов (с 2018 года не учитывается)

Яндекс

Проанализировав письма за последние два года в нашу поддержку по вопросам индексирования, мы выяснили, что одной из основных причин медленного скачивания документов является неправильно настроенная директива Crawl-delay в robots.txt […] Для того чтобы владельцам сайтов не пришлось больше об этом беспокоиться и чтобы все действительно нужные страницы сайтов появлялись и обновлялись в поиске быстро, мы решили отказаться от учёта директивы Crawl-delay.

Когда робот Яндекса сканирует сайт как сумасшедший и это создает излишнюю нагрузку на сервер. Робота можно попросить «поубавить обороты».

Для этого нужно использовать директиву Crawl-delay . Она указывает время в секундах, которое робот должен простаивать (ждать) для сканирования каждой следующей страницы сайта.

Для совместимости с роботами, которые плохо следуют стандарту robots.txt, Crawl-delay нужно указывать в группе (в секции User-Agent) сразу после Disallow и Allow

Робот Яндекса понимает дробные значения, например, 0.5 (пол секунды). Это не гарантирует, что поисковый робот будет заходить на ваш сайт каждые полсекунды, но позволяет ускорить обход сайта.

User-agent: Yandex Disallow: /wp-admin Disallow: /wp-includes Crawl-delay: 1.5 # таймаут в 1.5 секунды User-agent: * Disallow: /wp-admin Disallow: /wp-includes Allow: /wp-*.gif Crawl-delay: 2 # таймаут в 2 секунды

Робот Google не понимает директиву Crawl-delay . Таймаут его роботам можно указать в панели вебмастера.

На сервисе avi1.ru Вы можете уже сейчас приобрести продвижение SMM более чем в 7 самых популярных социальных сетях. При этом обратите внимание на достаточно низкую стоимость всех услуг сайта.

Robots.txt — играет очень важную роль в индексации. Правильный robots.txt — вообще очень важен. А насколько он правильный? А кто так сказал? А точно ли это поможет в продвижении ресурса в поисковых системах? Масса подобных вопросов возникала и у меня, когда я оптимизировал и искал информацию в интернете об этом. В принципе, роботсом я заинтересовался еще когда у меня был сайт на Ucoz (возможно, кстати, вам понравится статья про ), благо там его можно было настроить, и я постиг основы.

Если говорить совсем уж просто: для правильного представления вашего ресурса. Например, поисковые роботы, при посещении и индексации вашего сайта, могут взять, да и проиндексировать ненужные системные элементы. Как правило, такие страницы не слишком пригодны для восприятия роботами, и потому они будут считаться плохо оптимизированными. Если этих самых страниц будет слишком много, поисковик может понизить ваш проект в выдаче.

В абсолютно противоположном случае, что не менее прискорбно, может оказаться так, что ваш сайт и вовсе будет закрыт для индексации. Такое случается не так уж часто, но вам все равно следует учитывать это.

Правильная настройка robots.txt для WordPress

Чтобы не лить воду, сразу скажу, что здесь есть два способа. Вы можете: либо настроить robots.txt через редактор плагина Yoast SEO (который ОЧЕНЬ рекомендован к установке), либо создать такой файл вручную (в блокноте, например), и разместить в корне сайта. Во втором случае, кстати говоря, стоит помнить, что размещать файл нужно так, чтобы он был доступен по адресу: site.ru/robots.txt .

Хотя, я думаю, что с этими мелочами вы итак разберетесь. Сосредоточимся на содержимом этого файла.

User-agent: * Disallow: /cgi-bin Disallow: /? Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: */embed Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Disallow: /tag/ # Закрываем для того, чтобы не индексировалось слишком много дублей. # Если вы хотите, чтобы метки индексировались, удалите это правило. Allow: */uploads User-agent: GoogleBot Disallow: /cgi-bin Disallow: /? Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Allow: */uploads Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif Allow: /wp-admin/admin-ajax.php User-agent: Yandex Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: /xmlrpc.php Allow: /wp-*.jpg Allow: /wp-admin/admin-ajax.php Allow: */uploads Allow: /wp-*.jpeg Allow: /wp-*.gif Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Clean-Param: utm_source&utm_medium&utm_campaign Clean-Param: openstat Sitemap: https://site.ru/sitemap.xml Sitemap: https://site.ru/sitemap.xml.gz # Указываем, если для создания карты использовали Google XML Sitemap Host: https://site.ru # Указываем с протоколом

Несколько очень важных моментов:

- Если вы используете/собираетесь , то вам необходимо будет разрешить для Яндекса доступ к xml-файлу

- Когда вы будете копировать содержимое в файл — лучше убрать комментарии (пояснения с #)

- Как я уже говорил, правило Disallow: /tag/ можно убрать. Лично я убрал метки из индексации из-за огромного количества дублей (страниц с одинаковым содержимым), т.к они пагубно влияют на продвижение.

- Если вы НЕ используете SSL сертификат (и https протокол), указывать http протокол в Host: НЕ нужно . Директива будет выглядеть как Host: www.site.ru или Host: site.ru .

Почему надо указывать правила для каждого робота?

Благодаря такому подходу, по мнению некоторых оптимизаторов и вебмастеров, можно добиться куда больших результатов в продвижении сайта. И ведь это логично: если в правилах есть прямые указания для каждого робота, то и индексировать они будут активнее и чаще.

Кто-то, кстати говоря, и вовсе расписывает огромное полотно для роботов всех мастей. Там и роботы, которые индексируют картинки (от гугла и яндекса), и роботы других поисковых систем, коих очень и очень много.

Выводы

Собственно, вот так должен выглядеть правильно составленный robots.txt для WordPress в 2018 году. Безусловно, есть еще масса всевозможных вариантов, однако я рекомендую остановиться именно на этом. Я и сам его использую, в чем вы можете убедиться лично (добавьте /robots.txt к адресу моего сайта).

Вообще любая оптимизация сайта (не важно SEO или какая-нибудь другая) начинается еще на стадии разработки.

Однако, очень часто сайт создается впопыхах, кем-попало (кого смогли найти за те деньги), без технического задания, а если оно и есть, то меняется прямо на ходу. Поэтому, ко мне часто поступают обращения с просьбой подготовить сайт на движке WordPress (поскольку популярная платформа) под SEO-оптимизацию.

Метатэги

Ок. Начнем с простого. Установим плагин «All In One SEO Pack» . Делается это в админке, в разделе «Плагины» , в подпункте «Добавить новый» .

На открывшейся странице, в строку поиска, вводите название плагина, ищите, устанавливаете, активируете.

После этого в окне редактирования или создания поста, ниже поля куда вы вводите текст, появляются поля для тайтла, дескрипшина и кейвордсов. Если не знаете что это или зачем, то вы ни шиша не понимаете в SEO. Но у меня для вас хорошая новость, вся инфа есть в интернете. Воспользуйтесь поиском Яндекса, Гугла, поищите на ютубе. Не тупите!

Про метатэги пишу в этом посте исключительно для комплекта. Даже настроек самого плагина не буду касаться. Это та часть SEO-оптимизации, которую лучше сделать одновременно с добавлением Сайтмапа и Роботса, о которых пойдет речь дальше. Почему? Потому, что это займет всего пару минут, а в будущем точно понадобится.

Sitemap.xml

Теперь добавим карту сайта. Это тоже делается с помощью плагина. Их много, но я предпочитаю тот, что зовется «Google XML Sitemaps» . Ставится ровно так же как и предыдущий.

Настраивается в разделе админки (левое вертикальное меню) «Настройки» , подпункт «XML-Sitemap» . Собственно, достаточно тупо снять галочку с пункта «Add sitemap URL to the virtual robots.txt file.» и сохранить (там есть кнопка сохранения, если пролистаете ниже).

Чтобы убедиться, что все работает, откройте в соседней вкладке ссылку типа http://ваш_сайт/sitemap.xml

Увидели что-то вроде этого?

Отлично. Не закрывайте вкладку. Она нам еще пригодится. А пока переходим в админку.

Robots.txt

Этот файл можно заливать без каких-либо плагинов. По FTP например. Но если нет доступа или хочется все проделать с комфортом, то… Ставим плагин. Как вы уже убедились на предыдущих примерах, это очень простое действие, но профессионалы берут за это деньги.

Итак, ставим плагин «WordPress Robots.txt File» . Опять-же, можете выбрать другой, который будет работать.

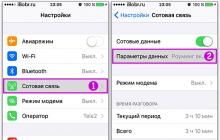

Ставим плагин, активируем, переходим в «Настройки» , в подпункт «Чтение» .

На открывшейся странице видим поле robots.txt

Если оно чем-то заполнено — удалите. Сейчас мы его заполним новым содержимым.

Перейдите по ссылке (желательно открыть эту ссылку в новой вкладке). На открывшейся странице вы можете видеть три поля и кнопку.

Скопируйте из адресной строки браузера адрес вашего сайта и вставьте его в поле с надписью «Введите адрес сайта» .

Теперь перейдите во вкладку с Сайтмапом. Помните, выше по тексту я просил ее не закрывать? Скопируйте из адресной строки путь к файлу sitemap.xml и вставьте в поле «Введите адрес вашего файла sitemap.xml» .

Нажмите кнопку «Создать robots.txt» .

Если все сделано правильно, в поле под кнопкой появится текст. Скопируйте его весь и вставьте в поле robots.txt , открытое в админке вашего сайта («Настройки», «Чтение») .

Если на открывшейся странице вы видите текст, который только что копировали и вставляли из поля, значит все установилось как надо.

Помогло? Зашли Админу на чай.

Зачем создавать файл robots.txt для сайта, размещенного на WordPress, и каким образом его лучше настроить? Неправильное использование этого файла может повредить индексации сайта и его продвижению в поисковых системах.

Корректная настройка избавит от дублей страниц и скроет ненужные страницы из результатов поиска.

Самый простой пример файла robots.txt для WordPress, который закрывает только администраторскую панель:

Где находится стандартный файл настроек роботс в WP?

Стандартный установщик Вордпресс не содержит файл роботс. Поэтому после установки CMS Вам потребуется создать его самостоятельно. В нашей статье вы найдете исчерпывающую информацию о всех командах, которые содержатся в этом файле. Также мы предлагаем Вам готовый работающий код для этого файла - вам достаточно скопировать его в свой файл роботс. Все что вам нужно сделать - создать свой файл, скопировать в него код, и добавить его в корневую папку Вашего сайта. После этого проверьте его коррекность для поисковых систем по нашей инструкции.

Виртуальный хостинг сайтов для популярных CMS:

Пример файла robots.txt, который вы можете использовать на своем сайте.

Вы можете выделить этот код и вставить на свой wordpress-сайт, заменив ссылки в разделе Host и Sitemap на адрес своего сайта.

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

User-agent: Yandex

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Host: http://site.ru/

Sitemap: http://site.ru/sitemap.xml

Файл robots.txt представляет собой простой текстовый файл, который вы можете создать в любом текстовом редакторе. Все инструкции, которые используются в robots.txt приводят к одному из трех результатов:

- Разрешение индексации – поисковые роботы могут просканировать весь контент.

- Полный запрет индексации – ничего из содержания сайта не будет сканироваться.

- Условное разрешение – задаются определенные директивы, которые указывают возможность сканирования конкретных папок и файлов.

Часто возникают разногласия по поводу того, что следует помещать в файл robots.txt. Имейте в виду, что этот файл не предназначен для решения проблем безопасности веб-сайта, поэтому если требуется закрыть роботам доступ к частному контенту, необходимо защитить паролем область, где хранится такая информация .

Как правило, файл robots.txt призван служить руководством для поисковиков, но они могут и не соблюдать эти инструкции. Вариант файла robots.txt приведен на скриншоте.

Давайте разберем, какие функции выполняет каждая строка в этом файле. Директива User-agent обозначает группу инструкций, предназначенных одному роботу или всем сразу. Существует два варианта ее применения:

- Если всем роботам задаются одинаковые указания, ставится знак звездочки (строка 1);

- если указано имя конкретного бота, то условия будут применимы только к нему (строка 15).

Разработчиками Яндекса отмечается, если в User-agent напрямую указан робот этой поисковой системы, то следует повторить в этом разделе те же общие инструкции, что используются для других поисковых роботов (строки 15-24). В противном случае роботом Яндекса будут учитываться только те команды, которые прописаны для него явно и проигнорируются остальные.

Disallow

Директива Disallow информирует роботов, какие директории не требуется индексировать. Например, если нужно, чтобы поисковики не индексировали фотографии на сайте, поместите файлы с этими фотографиями в одну папку и закройте к ней доступ.

Для сайта, созданного на WordPress, обязателен запрет на индексацию админки, то есть папки wp-admin. Дополнительно можно запретить индексацию рубрик, архивов и тэгов, хотя при использовании SEO-плагинов на WordPress эти запреты устанавливаются в настройках плагинов. В приведенном примере также от возможного попадания в индекс закрыты папки шаблона и кешированного контента.

Allow

Директива Allow позволяет сообщить роботу, что он может увидеть файл в папке, запрещенной другими инструкциями. В примере этой директивы нет, т.к. этот файл работает по принципу «что не запрещено – то разрешено».

Host и Sitemap

Директива Host сообщает об адресе основного зеркала сайта. Команда Sitemap предназначена для любых роботов, она отмечает расположение xml-файла со структурой сайта и облегчает индексацию страниц поисковиками.

Куда загружать файл robots.txt в WordPress

При отсутствии на сайте файла robots.txt, следует его создать. Можно использовать программу «Notepad++» в среде Windows или «TextEdit» для Mac.

- Создайте новый текстовый файл, запишите нужные директивы и сохраните на компьютере под названием robots.txt.

- Подключитесь к серверу хостинга через файловый менеджер и скопируйте в корневой каталог (1) веб-сайта файл robots.txt (2).

- В адресной строке наберите /robots.txt сразу после названия домена и убедитесь, что содержимое файла отображается браузером. Если вы используете поддомены, нужно создавать robots.txt для каждого поддомена.

Проверка роботс тхт Яндексом и Google - правильно ли работает файл?

Рекомендуется протестировать файл robots.txt, чтобы проверить, что он работает именно таким образом, как ожидается от помещенных в него инструкций. Перед анализом, убедитесь, что сайт зарегистрирован в инструментах веб-мастера, которые предлагаются поисковиками Google и Яндекс.

Для проверки Яндексом перейдите в кабинет веб-мастера по ссылке https://webmaster.yandex.ru . Выберите меню «Инструменты» и подменю «Анализ robots.txt».

Чтобы проверить файл в Google пройдите по ссылке https://www.google.com/webmasters/tools . В меню «Сканирование» нужно выбрать пункт «Инструмент проверки файла robots.txt».

Обе системы позволяют отправить файл robots.txt на проверку, после чего выдают результаты анализа и сообщения об ошибках, если они были обнаружены.

Для чего нужен robots.txt на вордпресс сайте?

Файл robots.txt – обыкновенный текстовый документ, размещенный на веб-сервере, он сообщает поисковым роботам о доступе к разделам сайта. При использовании этого файла можно задавать инструкции, например, запретить поисковикам индексировать служебные файлы и категории сайта, указать основную версию сайта и путь к карте сайта в формате xml. Прежде чем поисковик проиндексирует сайт, на него зайдет робот, например, Googlebot или Yandex, и просканирует файл robots.txt на предмет команд о том, какие страницы разрешено посещать и сохранять в результатах поиска.

Чтобы проверить, имеется ли на сайте файл robots.txt, задайте в адресной строке /robots.txt сразу после названия домена. В случае когда этот файл отсутствует, роботы-поисковики обладают полным доступом к вашему сайту. При этом в выдаче поиска могут оказаться ссылки на админпанель и вся информация, которую следует скрыть от посторонних. В связи с этим выделяют ряд причин, по которым потребуется использование файла robots.txt:

- На сайте есть контент, который вы хотите заблокировать от показа в поисковых системах, например, дубли страниц или результаты внутреннего поиска по сайту, личный кабинет пользователя или корзина покупателя.

- Вы хотите точно настроить доступ к сайту для известных роботов.

- Вы используете платные ссылки или рекламные объявления, требующие специальных инструкций для роботов.

- Вы разрабатываете сайт в режиме реального времени, но пока не хотите, чтобы поисковые системы индексировали его.

- Вы хотите сообщить поисковым роботам, где расположен файл навигации по сайту sitemap.

Каждая из этих ситуаций может быть исправлена разными способами, однако настройка файла robots.txt поможет реализовать их все сразу в одном месте, поскольку большинство веб-мастеров имеют доступ к сайту, необходимый для создания и использования файла robots.txt.

От автора: одним из файлов, которые используют поисковики при индексации вашего сайта, есть файл robots.txt. Не сложно понять из названия файла, что он используется для роботов. И действительно, этот файл позволяет указать поисковому роботу что можно индексировать на вашем сайте, а что вы не хотите видеть в поисковом индексе. Итак, давайте посмотрим, как настроить robots txt для сайта WordPress.

Статей на эту тему в сети множество. Практически в каждой из этих статей можно найти свой вариант файла robots txt, который можно взять и использовать практически без правок на своем сайте WordPress. Я не буду в очередной раз переписывать в данной статье один из таких вариантов, поскольку особого смысла в этом нет — все эти варианты вы без труда сможете найти в сети. В этой же статье мы просто разберем, как как создать robots txt для WordPress и какой минимум правил там должен быть.

Начнем с того, где должен располагаться файл robots.txt и что в него писать. Данный файл, как и файл sitemap.xml, должен быть расположен в корне вашего сайта, т.е. он должен быть доступен по адресу http://site/robots.txt

Попробуйте обратиться по такому адресу, заменив слово site адресом вашего сайта. Вы можете увидеть при этом примерно такую картину:

Хотя можете увидеть и вот такую картину:

Странная ситуация — скажете вы. Действительно, адрес один и тот же, но в первом случае файл доступен, во втором — нет. При этом если заглянуть в корень сайта, то никакого файла robots.txt вы там не обнаружите. Как так и где же находится robots.txt в WordPress?

Все дело в простой настройке — это настройка ЧПУ. Если на вашем сайте включены ЧПУ, тогда вы увидите динамически сгенерированный движком robots.txt. В противном случае будет возвращена ошибка 404.

Включим ЧПУ в меню Настройки — Постоянные ссылки, отметив настройку Название записи. Сохраним изменения — теперь файл robots.txt будет динамически генерироваться движком.

Как видно на первом рисунке, в этом файле используются некие директивы, задающие определенные правила, а именно — разрешить или запретить индексировать что-либо по заданному адресу. Как несложно догадаться, директива Disallow запрещает индексирование. В данном случае это все содержимое папки wp-admin. Ну а директива Allow разрешает индексирование. В моем случае разрешено индексирование файла admin-ajax.php из запрещенной выше папки wp-admin.

В общем, поисковикам этот файл, конечно, без надобности, даже и не представляю, из каких соображений WordPress прописал это правило. Ну да мне и не жалко, в принципе

К слову, я специально добавлял выше фразу «в моем случае «, поскольку в вашем случае содержимое robots.txt уже может отличаться. Например, может быть запрещена к индексированию папка wp-includes.

Кроме директив Disallow и Allow в robots.txt мы видим директиву User-agent, для которой в качестве значения указана звездочка. Звездочка означает, что идущий далее набор правил относится ко всем поисковикам. Также можно вместо звездочки указывать названия конкретных поисковиков. Файл robots.txt поддерживает и другие директивы. Я на них останавливаться не буду, все их с примерами можно посмотреть в консоли для веб-мастеров Гугла или Яндекса. Также можете прочесть информацию на данном сайте .

Как создать robots txt для WordPress

Итак, файл для поисковых роботов у нас есть, но вполне вероятно, что он вас не устроит в текущем виде. Как же составить свой файл. Здесь есть несколько вариантов. Начнем с первого — ручное создание файла. Создайте обычный текстовый документ в блокноте и сохраните его под именем robots с расширением txt. В этом файле запишите необходимый набор правил и просто сохраните его в корень вашего сайта WordPress, рядом с файлом конфигурации wp-config.php.

На всякий случай проверьте, что файл загрузился и доступен, обратившись к нему из браузера. Это был первый способ. Второй способ — это все та же динамическая генерация файла, только теперь это сделает плагин. Если вы используете популярный плагин All in One SEO, тогда можно воспользоваться одним из его модулей.